Residual Connection

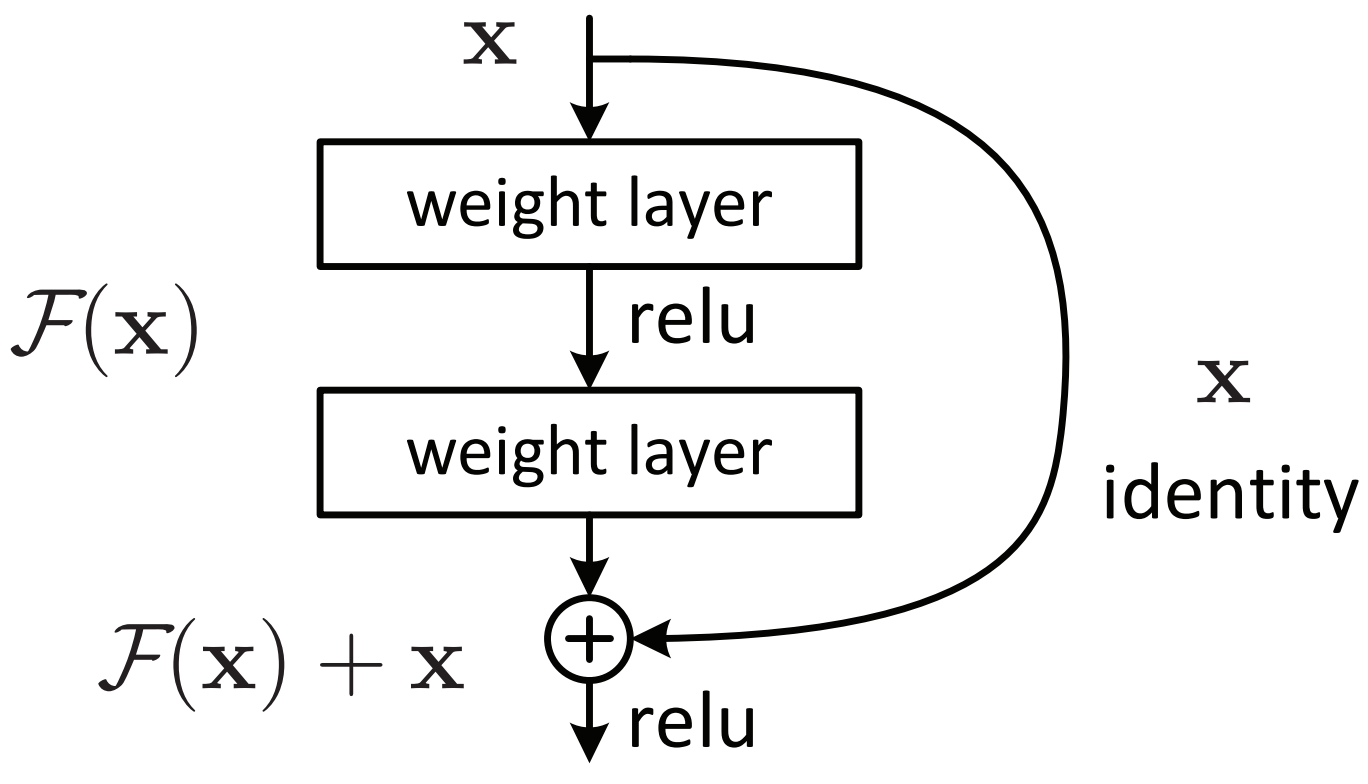

18 Dec 2020Residual Connection은 Skip Connection이라고도 불리는데 연산 후 input x를 추가적으로 더해주는 방법이다.

residual connection을 통해 각 layer들이 작은 정보들을 추가적으로 학습함으로써 각 계층이 배워야 할 정보량을 줄여준다.

residual connection을 사용하지 않는 plain layer의 경우 기존에 학습한 정보를 보존하지 않고 변형시켜 새롭게 정보를 생성하기 때문에 층이 깊어질 수록 한 번에 학습해야 할 정보가 너무 많아져서 학습이 어려워진다.

residual block에서는 y=f(x)+x 처럼 기존의 입력인 x가 보존되기 때문에 기존에 학습한 정보를 보존하고, 거기에 추가적인 정보를 학습한다. 그래서 이전 레이어에서 학습한 정보를 연결해서 해당 층에서는 추가적으로 학습해야 하는 정보만 학습한다.

skip connection에서 정수배나 실수배, convolution 연산 등을 다양하게 적용할 수 있다.