Batch normalization & Layer normalization

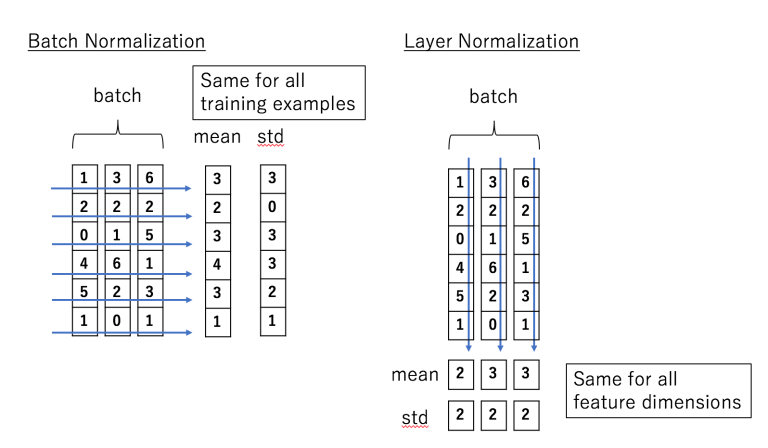

18 Dec 2020batch normalization과 layer normalization은 둘 다 값들이 심하게 차이나는 정도를 줄이기 위해 사용되는 방법인데, batch normalization은 각 feature의 평균과 분산으로 구해서 batch의 각 feature을 정규화 하는 방법이고, layer normalization은 각 input의 feature들에 대한 평균과 분산을 구해서 batch의 각 input을 정규화하는 방법이다[1].

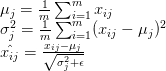

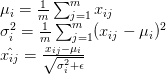

그래서 위와 같이 구한 평균과 분산을 사용해서 아래와 같은 방법으로 각각의 값들을 정규화 시켜준다[2].

batch normalization:

layer normalization:

출처:

[1] Batch Norm vs Layer Norm

[2] Weight Normalization and Layer Normalization Explained